Le Fake News non sono entrate nel panorama informativo da pochi anni ma sono sempre esistite da quando esiste l’informazione. Non voglio qui disquisire sulla vera definizione di Fake News: Che sia una pura notizia falsa o una notizia falsa creata ad hoc per colpire qualche personaggio pubblico poco importa.

Qualunque sia la natura della Fake News oggi giorno si discute sulla possibilitá di attuare qualche tipo di controllo o filtro per ridurne gli effetti “sociali”. Il fatto che ai giorni nostri le Fake news si presentino in gran numero attraverso la rete sembra motivare questa falsa convinzione che sia necessario attivare dei filtri per preservare la purezza dell’informazione. Questo concetto é se stesso una Fake News perché non é praticamente applicabile e chi lo afferma dice una falsitá.

Nelle scorse settimane prima il PD con Renzi e poi il M5S con Di Maio hanno dichiarato che servono dei controlli per verificare la veridicitá delle informazioni presenti in rete. Dicono che bisognerebbe responsabilizzare le aziende che convogliano le informazioni sul Web come Facebook, Google etc. in modo che attivino loro stesse dei controlli per poter verificare la veridicitá delle informazioni prima di pubblicarle. Di seguito alcuni numeri per capire perché queste teorie dirigiste non sono praticabili.

Fattore Economico

Le grandi aziende IT del Web (Service Internet Provider) hanno un modello di business abbastanza classico nonostante siano una realtá nuova nel panorama economico. I grandi Over The Top ovvero le aziende che offrono contenuti, applicazion e nuovi servizi IT senza possedere una vera e propria infrastruttura di rete, in gran parte si appoggiano su un modello di business basato sulla pubblicitá. Nella cosiddetta New Economy il modello non é tanto diverso da quello che facevano le televisioni private negli anni 80. Le nuove aziende della New Economy hanno inoltre un modello semi-monopolistico. Il primo che arriva si prende tutto: Facebook per il social, Google per i motori di ricerca, Google-Youtube per il Video Social, WhatsApp per la messaggistica OTT, Twitter per il Social Messaging , Amazon per l’e-commerce etc. Questa posizione di monopolio porta ovviamente ad un enorme volume in termini di guadagni.

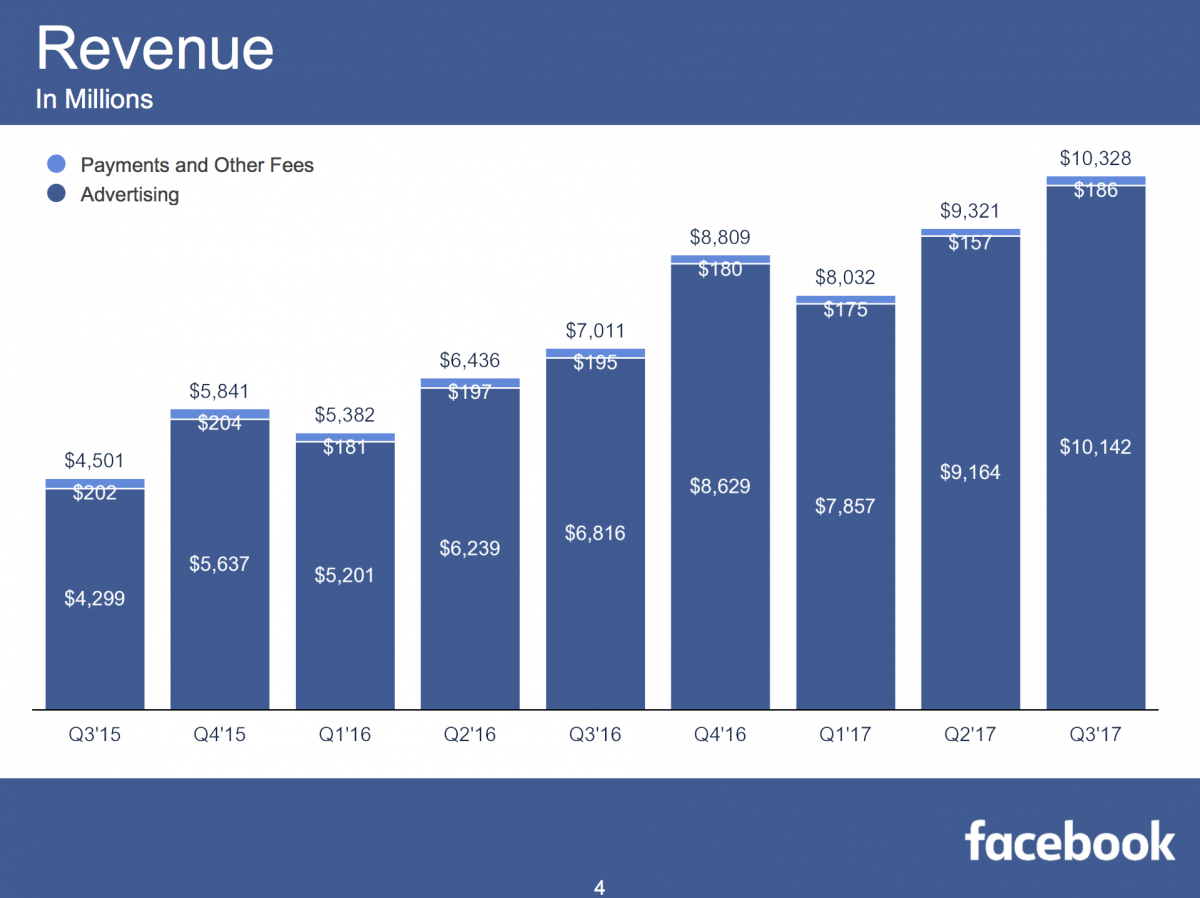

Qui sopra i Guadagni di Facebook in cui come si vede la pubblicitá conta quasi al 100%.

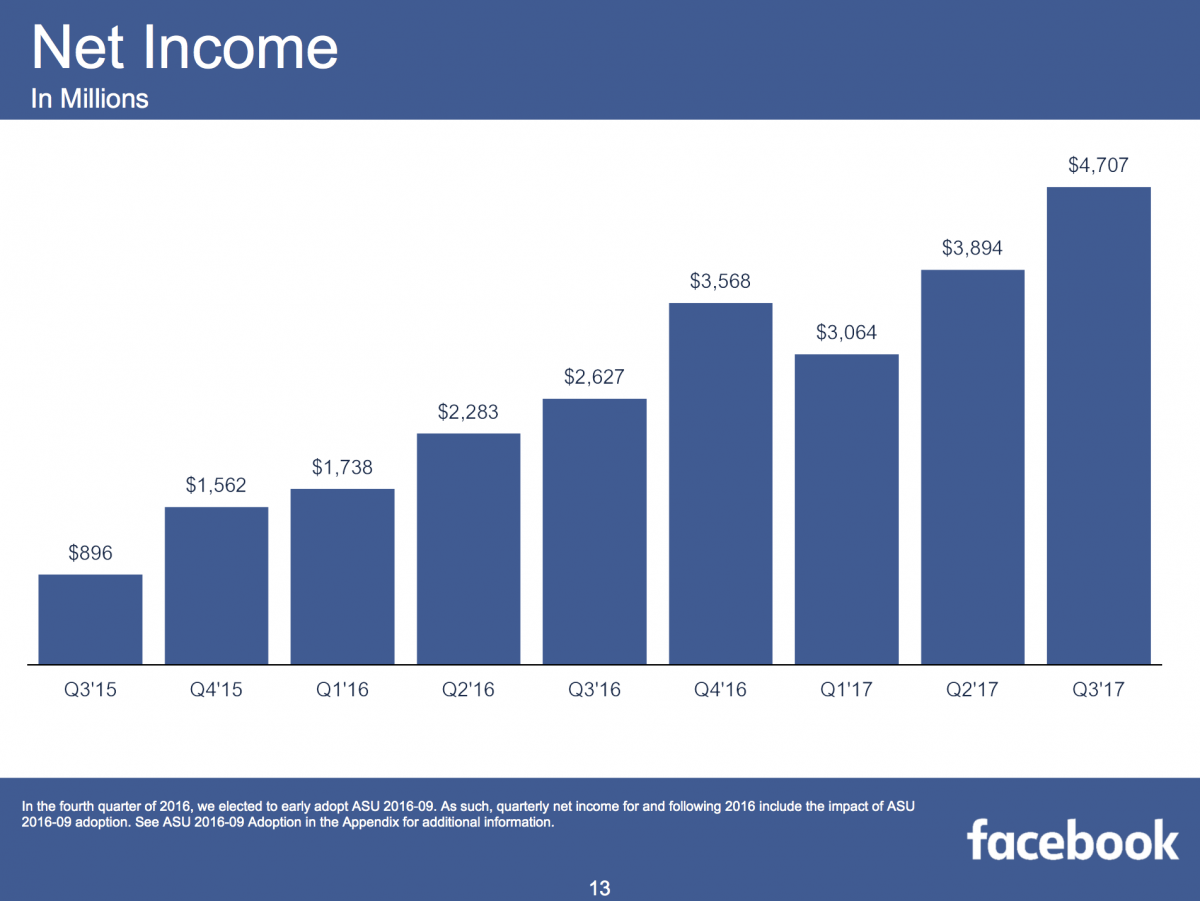

La corsa di Facebook e la sua posizione di monopolio ha portato l’azienda da un guadagno netto nel 2015 di 900Milioni di $ agli odierni quasi 5Miliardi. 5 volte il valore in 2 anni. Non male.

Questo per far capire che l’obiettivo di queste aziende é di far girare l’informazione qualunque essa sia, creare audience e vendere pubblicitá. Non c’é interesse né di veicolare informazione buona né informazione cattiva ma solo di far muovere le informazioni, generare “click” e guadagnare in pubblicitá.

Capiamo bene che accusare Facebook di mancati controlli é fuori da ogni logica perché non é responsabilitá dell’azienda controllare i contenuti condivisi dai propri utenti a meno di plateali infrazioni dell’ordinamento giuridico.

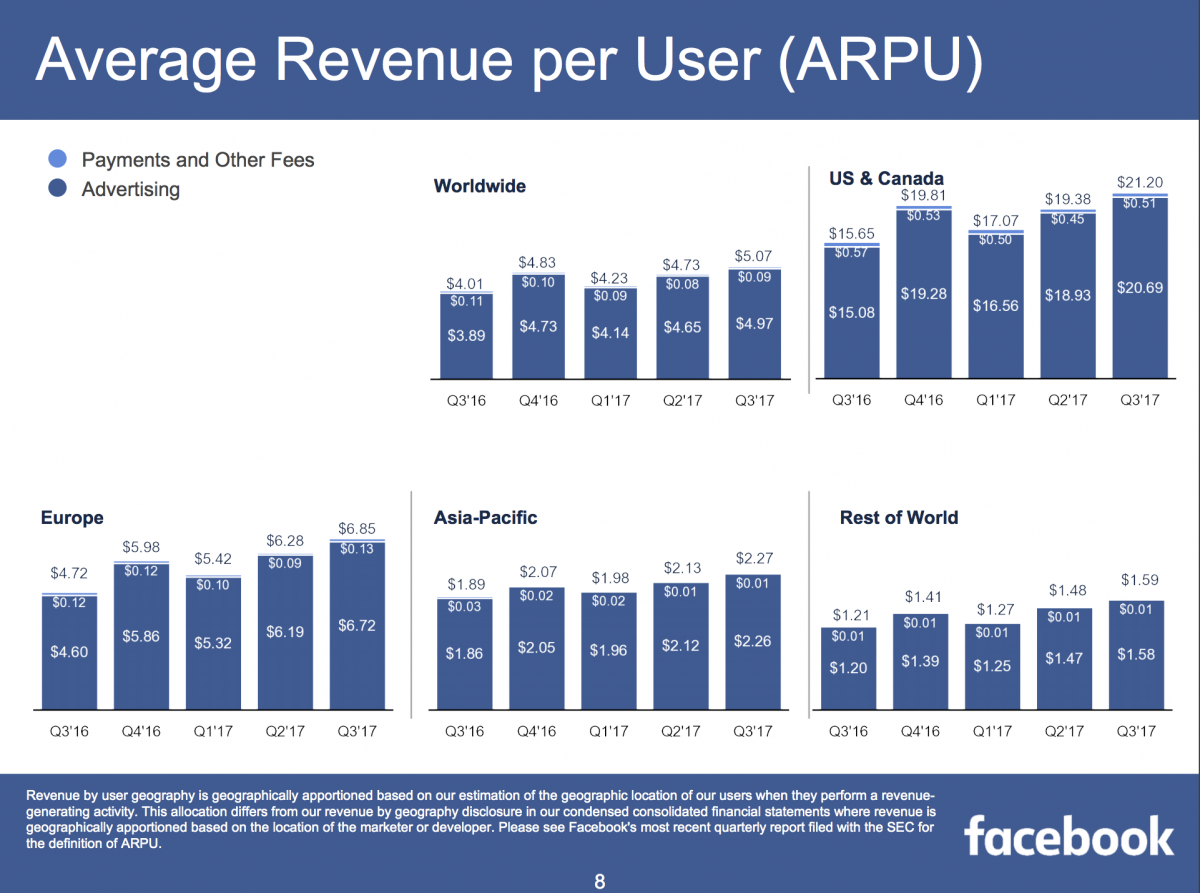

Per Facebook quello che é importante é l’utente non quello che condivide. L’importante é che l’utente faccia traffico. Infatti ogni utente ha un valore unitario di guadagno per Facebook (ARPU Average Revenue Per User). In Europa un utente Facebook vale 6.85$.

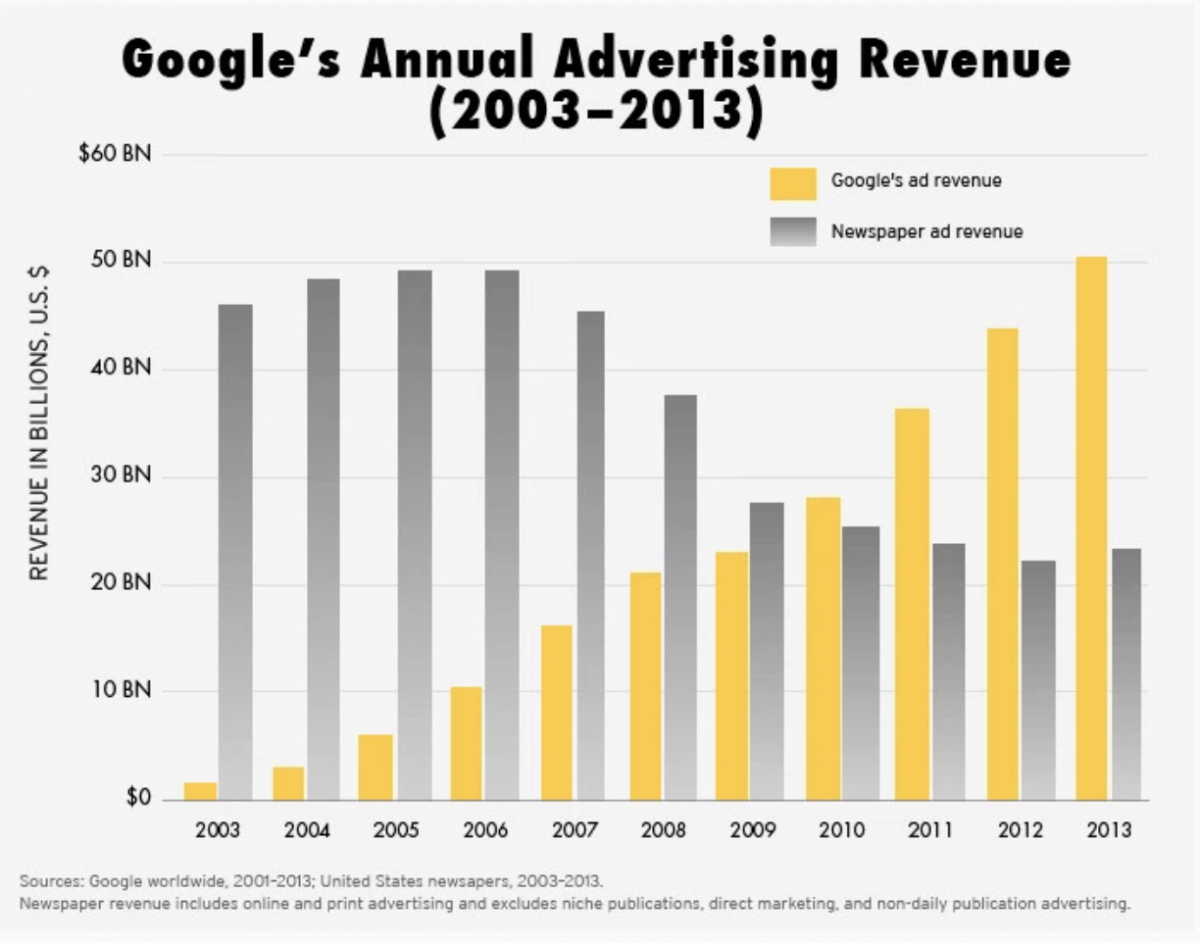

Qual’é il legame con l’informazione in questo caso? Queste aziende prendono i soldi della pubblicitá che prima era ad uso esclusivo dell’editoria ovvero dell’informazione certificata. Vedi sotto.

Il flusso delle informazioni e la pericolosa frammentazione digitale

Il grosso problema dell’informazione oggi non é tanto la Fake News in sé ma quanto il fatto che non si ha piú una chiara delimitazione fra fonti certificate/professionali con quelle scarse o addirittura false. Tutte le informazioni sono presentate alla persona attraverso nuovi canali (i social) che non sono canali ufficiali di propagazione dell’informazione né tantomeno come detto prima si propongono di sostituirli. La nuova comunicazione fra le persone ha preso la strada dei social per colpa delle persone stesse che hanno cambiato abitudini.

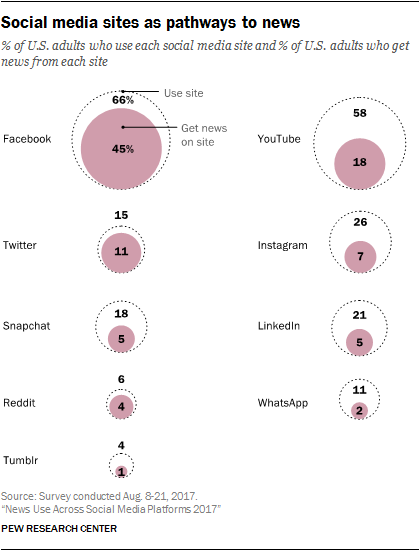

Nel grafico sotto si vede chiaramente qianto i Social siano diventati i luoghi in cui le persone acquisiscono la maggior parte delle informazioni (vere o false che siano). Non attraverso canali informativi professionali ma attraverso media che di norma non sono costruiti per informare ma solo per far muovere l’informazione. L’utente quindi, se non attento puó accedere a informazioni, parziali, scarse o addirittura false perché il social é diventato il nuovo contenitore senza filtri dove ognuno puó contribuire senza limiti.

Questo non implica che i Social debbano essere sottoposti a filtri o controlli “China Style”, ma semplicemente che la Fake News é il risultato di un fenomeno inarrestabile di diffusione delle informazioni attraverso canali non convenzionali.

Facile accusare il giornalismo di essere di parte o di pessimo livello ma resta il fatto che ogni giornalista gode di libertá di pensiero e opinione ma ha il dovere di riportare notizie vere e provate se non vuole incorrere in denunce. Il mondo editoriale invece é sotto forte pressione economica perché la sua fonte principale di guadagni (pubblicitá) si sta spostando altrove (vedi grafico precedente di Google). Gli incubatori di pubblicitá e guadagni basati sul flusso di informazioni sono proprio i nuovi canali che non certificano né controllano l’informazione stessa.

Pensare che l’informazione di rete sia la nuova via attraverso la quale il popolo oppresso finalmente conosce la veritá sempre nascosta dai poteri forti é semplicemente una falsitá . La rete é un grande mezzo di comunicazione ma per la sua assenza di controlli puó portare ad un inbarbarimento della societá se non viene preso con cautela. Quella che puó sembrare libertá di informazione puó essere invece il nuovo medioevo. Basta guardare cosa é successo negli ultimi tempi sulla discussione dei vaccini. La diffusione di notizie spesso troppo generiche hanno seriamente messo in discussione una delle piú grandi scoperte della medicina.

Questo di nuovo non vuol dire che servano i controlli perché sono impossibili ma semplicemente una nuova coscienza su quello che si legge che spesso deve essere accompagnato da accorgimenti minimi per non incappare in disinformazione.

Questo nuovo fenomeno di mega agglomerato di informazioni vere, scarse, false, non certificate nei nuovi contenitori sociali va sotto il nome di Frammentazione Digitale ed é spiegato in breve in questo video.

Filtrare o controllare é praticamente impossibile

Chi racconta che bisogna forzare i vari Facebook ad applicare dei filtri per il controllo delle informazioni non sa cosa sta richiedendo in termini di sforzo. Il filtraggio e controllo delle informazioni non é nelle prerogative dei Social e quindi la richiesta é di per se inutile. Ma se anche un Primo Ministro (primitivo) chiedesse che vengano applicate delle regole ai social qui sotto alcuni i numeri di cosa vorrebbe dire in termini di elaborazione:

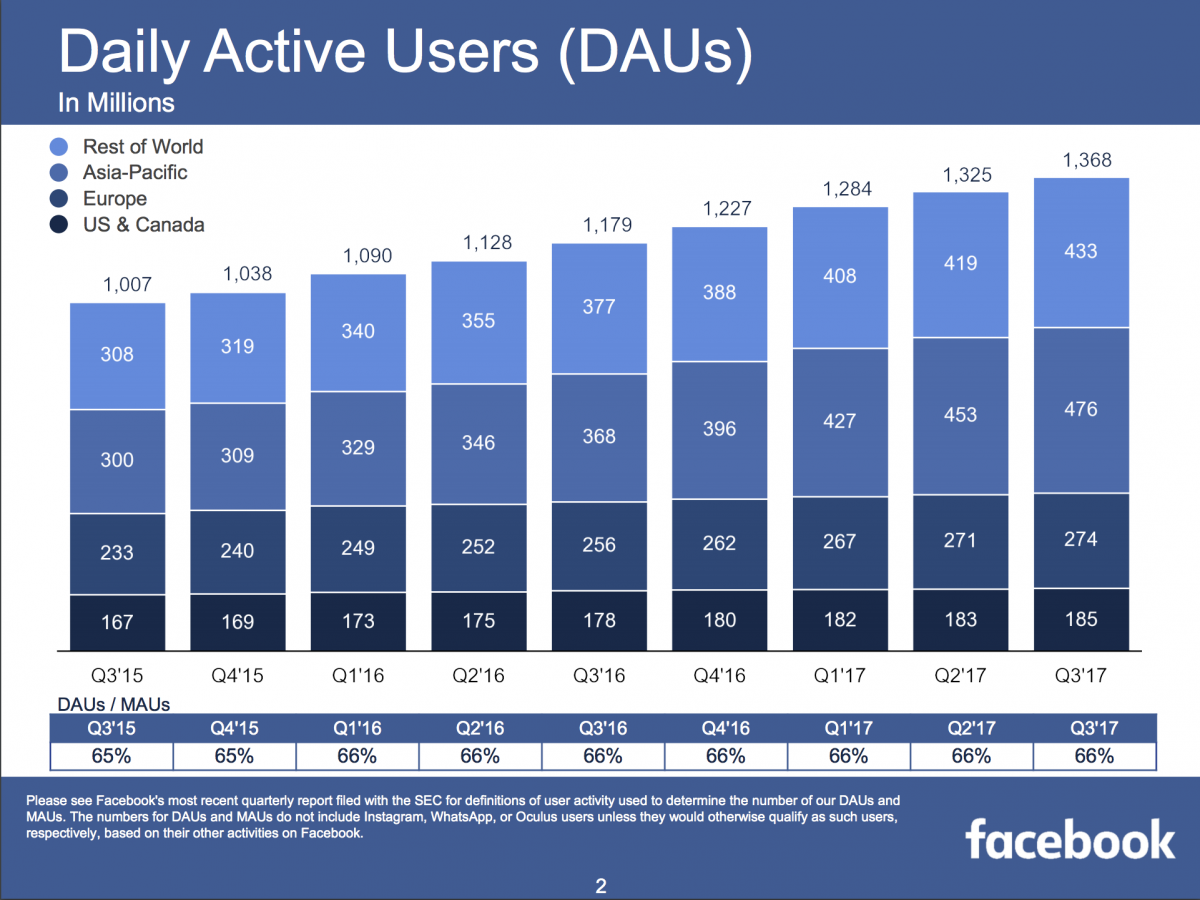

Questo il numero giornaliero di utenti attivi su Facebook: 1,3 Miliardi di persone

Lo Facciamo ancora un filtro?

E gli altri OTT? Qui sotto la mappa completa del mondo Social. Certo non tutti hanno 1,3 Miliardi di utenti attivi al giorno ma il filtri e i controlli vanno fatti su tutti?

Lo Facciamo ancora un filtro?

Ma quante “transazioni informative” avvengono su internet ogni minuto?

Dobbiamo controllarle tutte caro Primo Ministro?

E la domanda rimane sempre la stessa… lo facciamo ancora questo filtro?

La risposta mi sembra a questo punto ovvia, non é possibile. Non perché non si voglia ma perché non si puó. Non é praticabile il controllo di questo tsunami informativo che la rete porta ogni secondo. La mole di utenti e file da controllare é troppo grande. Lo sforzo richiederebbe un investimento difficilmente affrontabile per chiunque.

La questione é che esistono politici che essi stessi generano Fake News solo per il fatto che ne parlano in questi termini. Persone che non hanno le conoscenze tecniche necessarie per capire il fenomeno ma che legiferano. Personaggi che promuovono la rete come nuova fonte di veritá ma nello stesso tempo chiedono i controlli. Persone che invocano la rete senza nemmeno sapere come funzioni veramente.

L’onda dei social é inevitabile, le Fake News una conseguenza ma i controlli non applicabili. Quello che serve é la responsabilizzazione delle persone davanti ai nuovi strumenti, la consapevolezza di quello che puó nascondere l’informazione dai social. Questo é ancora possibile, basta forse smetterla di guardare alle Fake News e alle Fake Person e concentrarsi su argomenti piú seri.